"AI 모델 학습 데이터에 아동 성 학대 사진 1000장 발견"

미 스탠퍼드대 인터넷 감시소(Observatory)는 최근 발표한 보고서에서 '레이온(LAION)-5B'라는 인기 오픈소스 이미지 데이터베이스에서 최소 1천8장의 아동 성적 학대 사진을 발견했다고 밝혔다.

'레이온-5B'는 영국 스타트업 스태빌리티 AI가 운영하는 '스테이블 디퓨전'과 같이 텍스트를 이미지로 변환해주는 AI 모델이다.

레이온 측은 "안전성을 확보하기 위해 문제가 되는 이미지를 제거하는 작업중에 있다"고 밝혔다.

그러나 AI가 이미지를 생성하려면 사진 몇 장만을 학습하면 되기 때문에 이런 사진이 1천 개 넘게 포함돼 있다는 점에 대해 우려의 목소리가 나오고 있다.

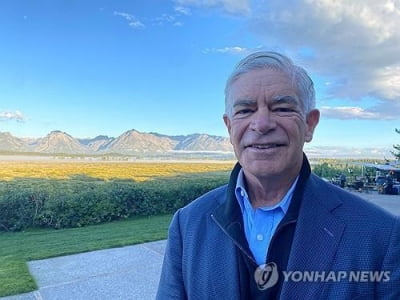

이 연구소 최고 기술자인 데이비드 티엘은 "AI가 기본적으로 이 이미지를 이용해 아동 성 학대와 같은 콘텐츠를 제작할 수 있다"고 말했다.

이어 이를 통해 아이들의 얼굴을 성인의 몸에 붙이는 것과 같이 소아성애자가 이전보다 불법 이미지를 쉽게 만들 수 있고 그 양도 증가하고 있다고 지적했다.

이 이미지들이 어떻게 이 '레이온-5B'의 데이터세트에 포함됐는지는 구체적으로 알려지지 않았다.

연구진은 다만, 데이터베이스 제작자들이 소셜미디어나 성인용 비디오 사이트, 공개된 인터넷에서 이미지를 수집하면서 실수로 추가된 것일 수 있다고 언급했다.

이 사진들은 수십억 개에 달하는 레이온-5B 데이터베이스의 극히 일부이지만, 이런 이미지가 포함됐다는 사실만으로 AI의 핵심인 데이터세트에 대한 우려를 보여준다고 보고서는 지적했다.

보고서는 이를 위해 아동 성 학대 콘텐츠와 당사자의 동의를 받지 않은 음란물을 데이터베이스에서 스크린하고 제거하기 위한 규약(프로토콜)을 마련해야 한다고 강조했다.

데이비드 티엘은 "이를 통해 AI 학습용 데이터세트에 콘텐츠 정보가 더 투명하게 포함될 수 있고, AI 모델은 노골적인 이미지를 생성하는 방법을 알지 못하도록 학습할 수 있다"고 말했다.

/연합뉴스

-

기사 스크랩

-

공유

-

프린트

![34년만 엔·달러 환율 160엔 돌파…환율 출렁인 이유는? [한경 외환시장 워치]](https://timg.hankyung.com/t/560x0/photo/202404/01.36562723.1.jpg)