메타, 사람처럼 동시에 여러정보 결합해 학습하는 AI모델 공개

-

기사 스크랩

-

공유

-

댓글

-

클린뷰

-

프린트

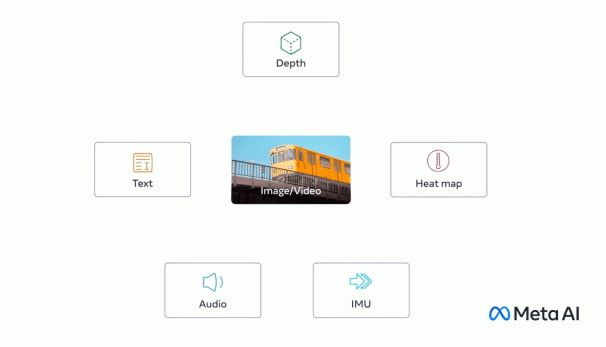

메타는 9일(현지시간) 새로운 오픈소스 AI 모델 ‘이미지바인드’ 연구논문을 공개하고 6가지 유형의 데이터를 동시에 입력받아 분석 및 학습할 수 있다고 밝혔다. △시각적 데이터(이미지·비디오) △열화상(적외선 이미지) △텍스트 △오디오 △3D 심도 △관성 측정(IMUs) 등 6종의 데이터를 하나의 임베딩 공간에 결합하는 최초의 AI 모델이다.

메타는 “이미지바인드는 사진 속 물체가 어떻게 소리를 내고 3D처럼 보이는지, 얼마나 따뜻하고 추운지, 어떻게 움직이는지에 대한 전체적인 이해를 제공한다”며 “다양한 유형의 데이터로부터 학습하는 멀티모달 AI 시스템을 만들기 위한 노력의 일환으로, 3D 및 IMU 센서를 결합해 몰입형 가상세계를 설계하는 등 새로운 시스템을 개발할 수 있다”라고 설명했다. 예를 들어 이 모델을 활용해 열대우림 소리나 혼잡한 시장 음성을 기반으로 이미지를 생성하는 등 오디오가 포함된 이미지를 만들 수 있다.

이미지바인드는 연구 프로젝트로 아직 실제 적용사례는 없다. 미국의 정보기술(IT) 전문매체 더버지는 “이미지바인드가 몰입형 다감각적 경험을 제공하는 생성AI의 미래”라며 “(이미지바인드에) 장거리 항해를 구현해달라고 요청하면 파도 소리뿐 아니라 발밑의 갑판 흔들림과 시원한 바닷바람까지 느낄 수 있게 해줄 것”이라고 평가했다.

메타는 “앞으로 촉각, 화법, 후각, 자기공명영상(fMRI) 뇌 신호 등 가능한 많은 감각을 연결하면 보다 풍부한 인간 중심 AI 모델 구형이 가능할 것”이라고 설명했다. 최진석 기자

최진석 기자 iskra@hankyung.com

![K팝 업계에도 '친환경' 바람…폐기물 되는 앨범은 '골칫거리' [연계소문]](https://img.hankyung.com/photo/202206/99.27464274.3.jpg)