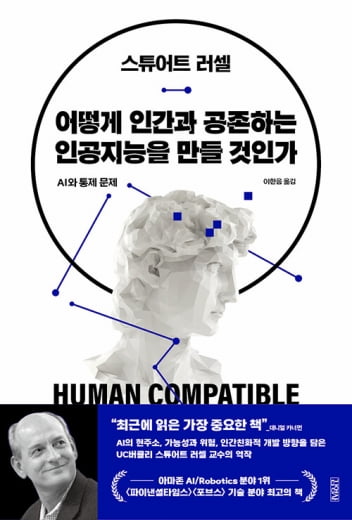

스튜어트 러셀은 전 세계 1500개 학교에서 인공지능 교재로 사용하는 ‘인공지능: 현대적 접근 방법’을 피터 노빅과 같이 쓴 교수이며, BAIR라는 ‘버클리 인공지능 연구소’와 ‘인지와 뇌과학 연구소’의 주요 멤버이다. 그는 또한 확률적 모델과 강화학습 외에도 지능의 기반이나 인공지능의 미래에 대한 여러 연구를 수행하는 최고 전문가 중 한 명이다.

그는 이 책에서 현재 인공지능 기술이 빠르게 발전했지만 아직 해결해야 할 많은 문제가 있음을 제시하고 있으며 개념적 돌파구로 언어와 상식, 개념과 이론의 누적 학습, 행동 발견하기, 정신 활동 관리하기 등 좀 더 도전적인 영역을 어떻게 개척할 것인가를 설명하고 있다. 초지능의 출현에 대해서 말을 아끼지만 많은 시간이 지나서 구현할 수 있을 것이라는 태도를 취하고 있다. 특히 일반 인공지능을 구현하고 이를 현명하게 통제해 인간 지능을 강화할 수 있다면 우리가 접하고 있는 가난, 질병, 사회 문제를 해결할 수 있어 인류에게 큰 이익이 될 것이라고 얘기한다.

그러나 그냥 긍정적인 입장이 아니라 인간 사회에서 발생할 수 있는 오용의 문제, 인간을 능가하는 경우에 겪을 수 있는 실존의 문제(고릴라 문제), 불완전한 문제와 가치 정렬 실패(미다스 왕 문제), 도구적 목표와 인간 선호 간의 충돌 등 그가 여러 에세이에서 거론했던 문제를 이 책에서 다시 정리해서 설명하고 있다.

현재 표준 모델로 볼 수 있는 인공지능에 목적 함수를 정하고 이 목적을 위한 수많은 데이터를 통해 학습을 시키는 방식에서 우리의 가치와 정렬하지 못한 목적이 사용되는 경우에서 현재 많은 문제가 발생하고 있다는 것이 그의 진단이다.

이 문제에 대한 그의 제안은 인공지능이 정해진 목적이 아닌 우리의 목적을 지속적으로 찾아내고 이를 통해 인공지능의 인센티브를 전환하게 만들자는 것이다. 이는 그가 지난 몇 년 동안 논문과 에세이를 통해 주장한 ‘역 강화학습(IRL)’ 방식을 의미한다.

특히 많은 사람이 존재하는 사회에서 인간이 갖는 선호를 어떻게 조율할 것인가 하는 문제에서 그는 공리주의 원칙을 강하게 주장한다. 특히 인공지능 연구자가 인간의 선호를 설정하는 일은 결코 있으면 안 된다고 말하면서, 우리가 흔히 얘기하는 단순한 공리주의가 아닌 좀 더 균형적이고 합리적인 방향을 위해 많은 철학자, 사회학자, 경제학자의 논의를 소개한다. 심지어 어벤저스의 타노스나 매트릭스까지 등장시키면서.

마지막으로 러셀 교수도 심층학습의 한계를 지적하는데, ‘더욱 크고 더욱 깊은 망과 더욱 많은 데이터 집합과 더욱 큰 기계를 만든다고 해서 인간 수준의 AI가 나오지 않는다는 것이다’라면서 ‘더욱 고등한 사고와 상징 추론’이 필수적이라는 딥마인의 하사비스 견해를 소개한다. 이를 설명 기반 학습과 인지과학의 덩이짓기(chunking)이라는 유형의 학습이 필요하다는 것을 제시하면서 마무리 짓는다.

물론 그가 공학자이기 때문에 때로는 인간 사고나 다수의 의사 결정, 사회 문제에 대한 접근이 때로는 매우 단순하게 보이기도 한다. 그러나 이 책을 통해 인공지능 연구자들이 어떤 문제를 생각해야 하며, 앞으로 풀어야 할 문제가 매우 어려운 문제임을 깨우칠 수 있다.

MIT의 물리학자이면서 유익한 인공지능 주창자 중 하나인 맥스 테그마크 교수(라이프 3.0의 저자)는 그가 인공지능의 진정한 개척자 중 한 명이며, 이 책이 ‘더욱 강력해진 인공 지능의 위험을 매혹적이고 설득력 있는 방식으로 설명할 뿐만 아니라 구체적이고 유망한 솔루션을 제안한다’면서 반드시 읽어야 할 책으로 적극 추천한다는 리뷰를 아마존에 올리기도 했다.

※책과얽힘

국내에서 보기 드문 과학기술 전문 큐레이팅 책방이다.서울 강남구청역 인근에 있다. 기술과 정책 전문가들이 수시로 모이는 사회적 공간, 커뮤니티 역할도 하고 있다. 모든 책은 공학박사인 주인장(한상기)이 엄선해 판매한다. 페이스북에서 책과얽힘을 검색해도 만날 수 있다.