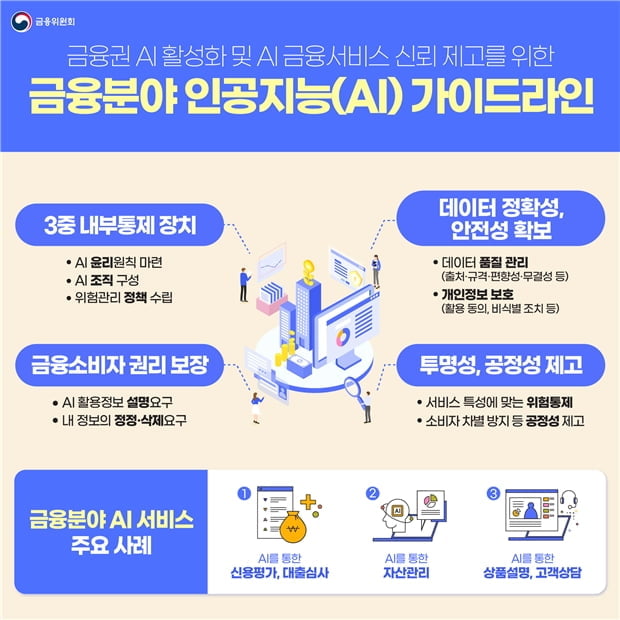

금융권 AI 윤리원칙·전담조직 만든다…3중 내부통제장치 도입

금융위원회는 8일 디지털금융협의회 데이터 분과회의를 열고 이 같은 내용의 금융분야 AI 가이드라인을 확정, 발표했다.

가이드라인에 따르면 AI 금융거래와 대고객서비스를 적용한 모든 금융업권은 △AI윤리 원칙 마련 △AI조직 구성 △위험관리정책 수립 등 3중 내부통제장치를 마련해야한다.

금융위는 회사별로 가치와 AI 활용 상황 등에 따라 AI 서비스 개발·운영시 지켜야 할 원칙과 기준을 수립해야 하며 AI의 잠재적 위험을 평가, 관리할 구성원의 역할과 책임, 권한을 기획-설계-운영-모니터링 등 서비스의 전 단계에 걸쳐 구체적으로 정의하도록 했다.

특히 신용평가나 대출심사 등 AI의 의사결정이 개인의 금융거래계약에 중대한 영향을 미치는 경우에는 이에 대한 내부통제와 승인절차 등을 마련하고 별도의 책임자를 지정해야 한다.

아울러 AI시스템 성능을 주기적으로 모니터링하고, AI 개발 환경의 보안취약성 점검 시스템 마련 등 위험완화 조치도 해야 한다.

금융소비자에게는 AI가 활용된다는 사실을 사전에 고지하고, 이의신청 등 권리구제 방안도 안내하도록 했다.

금융사는 AI를 통해 신용평가, 보험가입 등 금융거래·계약체결 여부를 결정한 경우에 고객에게 `설명요구·정정요구권`이 있음을 고지해야 한다.

도규상 금융위 부위원장은 "AI 기술의 안전성 등에 대한 사회적 신뢰가 충분하지 않은 만큼, AI 가이드라인을 통해 AI 금융서비스에 대한 사회적 신뢰를 공고히 하고 지속가능한 금융혁신 환경 조성해야 할 것"이라고 말했다.

가이드라인은 준비 기간을 거쳐 연내에 시행되며 각 금융업권협회는 기능과 서비스별 특성을 고려해 가이드라인을 구체화한 세부 실무지침도 3분기 내에 마련할 계획이다.

전민정기자 jmj@wowtv.co.kr

ⓒ 한국경제TV, 무단 전재 및 재배포 금지

-

기사 스크랩

-

공유

-

프린트

![MBC '뉴스데스크' 앵커 출신 박혜진, 파격 근황 봤더니 [이일내일]](https://timg.hankyung.com/t/560x0/photo/202404/01.36513659.3.jpg)