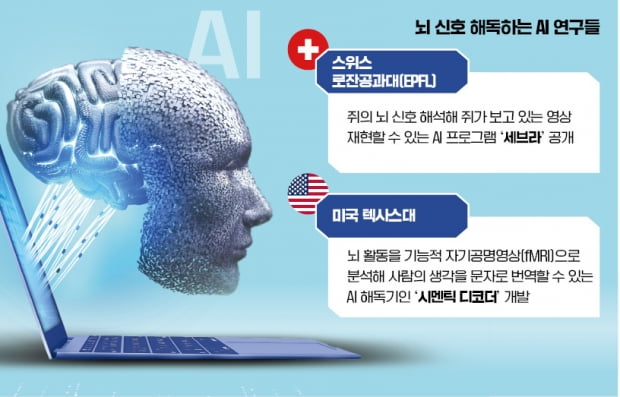

뇌 과학과 만난 AI…생각만하면 글·영상으로 바꿔 보여준다

로잔공대 연구진, 신기술 공개

AI로 뇌 활동 데이터 학습시켜

프레임 예측해 영상으로 보여줘

뇌활동-시각적 입력 '고리' 규명

시각 장애인 등에 활용 기대

텍사스대, 사람 머릿속 생각

AI로 읽어내는 해독기 개발

뇌에 침 꽂지 않아도 측정 가능

○“생각을 영상으로 재현”

연구진은 수집한 뇌 활동 데이터를 딥러닝 알고리즘인 ‘세브라’란 AI 프로그램에 학습시켜 뇌 신호를 비디오의 특정 프레임에 매핑했다. 그런 다음 새로운 쥐에게 동일한 영상을 시청하게 하면서 뇌 활동을 측정하고, 이 뇌 활동 데이터를 세브라로 해석했다.

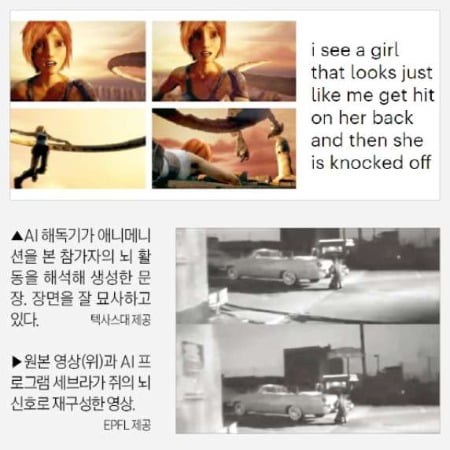

세브라는 쥐가 보고 있는 프레임을 실시간으로 예측할 수 있었고, 연구진은 예측한 프레임을 영상으로 변환했다. 그 결과 원본과 거의 일치한 영상을 제작할 수 있었다. 화면에 약간의 끊김과 어색한 움직임이 있었지만 원본과 거의 동일한 수준이었다.

연구팀은 “쥐가 돌아다니는 등 완전히 주의를 기울이지 않은 경우를 제외하면 원본 영상을 재구성할 수 있었다”며 “10년 전에 뇌의 매우 단순한 신호만 해석할 수 있었지만 이젠 전체 영상을 변환할 정도로 발전했다”고 설명했다.

이번 연구를 통해 사람의 기억과 꿈을 영상으로 재현할 수 있게 된 건 아니다. 세브라가 사전에 해당 영상으로 훈련받았기에 이 작업을 수행할 수 있었다. 영상의 배경과 관련한 데이터를 확보한 상태에서 실험이 진행됐다는 뜻이다.

연구진은 세브라가 신경학적 기능과 뇌가 자극을 해석하는 방법에 대한 통찰력을 제공할 것이라고 봤다. 뇌 활동 패턴과 시각적 입력 사이의 연결을 밝혀내고, 이를 통해 시각 장애가 있는 이들에게 관련 감각을 생성하는 방법을 개발할 수 있을 것으로 기대했다. 치매 등 뇌 질환을 진단하고 치료하는 데에도 도움이 될 것으로 내다봤다.

○말하지 않아도 문장으로 ‘척척’

이 기술의 특징은 기존 뇌 활동 분석에 쓰이는 탐침 등 침습 장치를 사용하지 않는다는 것이다. 수술을 통해 뇌에 전극을 삽입하는 등 인체에 부담을 주지 않아도 된다. 시멘틱 디코더는 뇌의 혈류 변화를 추적하는 방식으로 생각을 읽는다.

연구진은 fMRI로 참가자 3명의 뇌 혈류를 스캔했다. 16시간 동안 팟캐스트를 들려주면서 각각의 참가자가 문장과 단어에 어떤 혈류 반응을 보이는지 확인했다. 이를 통해 일종의 ‘뇌 활동 지도’를 만들었다.

이와 함께 참가자가 특정 단어를 생각한 뒤 어떤 단어를 떠올릴지 예측하기 위해 대규모언어모델(LLM)을 활용했다. 연구진은 오픈AI의 챗GPT나 구글 바드와 같은 생성AI 프로그램이 사용하는 ‘트랜스포머’ 기술을 이용했다고 설명했다. 트랜스포머는 문장 속 단어와 단어의 관계를 분석해 맥락과 의미를 학습하는 역할을 한다.

분석 결과 시멘틱 디코더는 완전하지는 않지만 참가자가 소리나 영상을 접했을 때 떠올리는 생각을 읽어냈다. 예를 들어 실험에서 참가자에게 “나는 아직 운전면허증이 없습니다”라고 말하면 AI는 “그녀는 아직 운전 배우기도 시작하지 않았습니다”라고 해석했다. “비명을 질러야 할지, 울어야 할지, 도망쳐야 할지 몰랐다. ‘나를 좀 내버려 둬!’라고 말했다”는 음성을 참가자에게 들려주자 AI는 뇌 신호를 감지한 뒤 “비명을 지르고 울기 시작하더니 그냥 ‘나를 내버려 두라고 했잖아’라고 말했다”로 해독했다.

또한 참가자들이 무음으로 애니메이션을 볼 때 AI는 어떤 장면인지 대략적인 내용을 잡아냈다. 연구진이 기술 정확도를 측정한 결과 참가자가 실제로 떠올린 생각과 해독된 내용이 절반에 가까운 일치율을 보였다. 향후 언어 장애, 전신마비 등 소통에 문제가 있는 이들에게 도움을 줄 수 있을 것으로 보이는 대목이다.

한계도 있었다. 한 사람에게 훈련된 AI 모델이 다른 사람의 뇌 활동을 읽어내지 못했다. 이 기술이 더 발달할 경우 이를 악용해 다른 사람의 생각을 훔쳐볼 수 있다는 우려의 목소리도 나왔다. 연구진은 “이 기술이 나쁜 목적으로 사용될 수 있다는 우려를 매우 심각하게 받아들인다”며 “사람들이 원할 때만 이 기술을 사용해 도움이 되기를 바란다”고 했다.

최진석 기자 iskra@hankyung.com

-

기사 스크랩

-

공유

-

프린트

![[커버스토리] 인공지능, 약인가 독인가…육성과 규제 사이](https://img.hankyung.com/photo/202305/AA.33488556.3.jpg)

![[오늘의 arte] 독자 리뷰 : 당신의 미술 취향은 무엇인가요](https://timg.hankyung.com/t/560x0/photo/202404/AA.36523699.3.jpg)