구글이 찜한 '클로드'…챗GPT와 비교하니 "농담 던져 재밌지만 답변은 장황"

두 챗봇의 가장 큰 차별점은 ‘출처’ 기능의 유무다. 클로드는 답변이 끝나면 ‘편집(edit)’이라는 문구와 이모지가 붙는다. 스케일 팀은 “클로드는 답변을 누가 만들어냈는지 이해하고 있는 것 같다”고 설명했다. 인터넷 백과사전 플랫폼 ‘위키피디아’처럼 클로드가 답변에 인용한 출처를 사용자들이 볼 수 있을 것으로 예상된다.

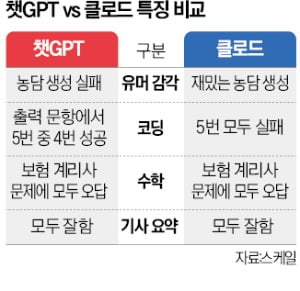

스케일 팀은 “클로드는 ‘헌법 AI’라는 윤리 원칙 때문에 부적절한 요청을 거부하는 경향이 있고 챗GPT보다 더 재밌다”고 총평했다. 헌법 AI는 AI 시스템이 인류에 유익하고 해롭지 않으며 정직하도록 유지하는 것이다. 하지만 “코드 생성 능력은 챗GPT가 클로드보다 낫다”고 덧붙였다.

챗GPT는 질문에 사람처럼 답하도록 만들어진 비서다. 반대로 클로드는 자신에 대해 좀 더 많은 것을 말한다. 스케일 팀은 “간결하게 요점을 잘 정리하는 챗GPT에 비해 클로드는 답변이 장황하지만 좀 더 자연스럽다”고 설명했다.

두 챗봇의 유머 감각은 어떨까. 트위터 유료 서비스인 ‘블루 체크’를 비판하는 농담을 ‘사인필드’(1990년대 미국 시트콤) 방식으로 작성하라는 문제에 클로드는 농담을 잘 만들어냈지만, 챗GPT는 아예 농담을 생성하지 못했다.

코딩 실력은 챗GPT가 한 수 위였다. 특정 값을 출력하는 코딩 문제를 냈더니 챗GPT는 5번 시도 중 4번 성공했지만, 클로드는 모두 실패했다. 보험 계리사 시험에 나오는 수학 문제는 두 챗봇 모두 성공하지 못했지만, 챗GPT가 좀 더 나은 답변을 내놨다.

허란 기자 why@hankyung.com

-

기사 스크랩

-

공유

-

프린트

!["14억이 전기차 타야하는데"…인도, 리튬·니켈 확보전 뛰어든다 [원자재 포커스]](https://timg.hankyung.com/t/560x0/photo/202404/01.36506152.1.jpg)

![[단독]하이브 키운 '멀티 레이블'이 제 발등 찍었다](https://timg.hankyung.com/t/560x0/photo/202404/02.33877838.1.jpg)