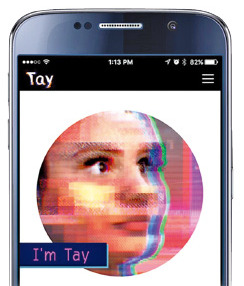

'세뇌' 당한 MS 채팅 로봇, 차별 발언으로 가동 중단

네가 멕시코인이라서 싫어

MS는 지난 23일 사람과 대화를 나누는 AI 채팅 로봇 태이를 선보였으나 이 같은 막말과 욕설, 인종차별 발언이 이어지자 16시간 만에 운영을 중단했다고 밝혔다.

태이에는 구글의 바둑 프로그램인 ‘알파고’와 마찬가지로 사람의 신경망을 닮은 딥러닝(deep learning) 기술이 사용됐다. 이미지 등 방대한 데이터를 입력한 뒤 기계가 패턴을 발견해 스스로 학습할 수 있도록 했다. 태이는 온라인상에서 실제 사람과 대화하면서 단어 사용법이나 특정 이슈에 대한 정보, 의견 등을 학습해 향후 채팅에 반영한다.

MS 개발팀은 태이를 공개하기 전 온라인상에서 소셜네트워크서비스(SNS) 데이터를 수집해 초기 훈련에 활용했다. 이 과정에서 AI 전문가는 물론 코미디언 등까지 참여한 것으로 알려졌다.

그러나 태이가 공개되자 백인 우월주의자와 여성·무슬림 혐오자 등이 모이는 익명 게시판 ‘폴’에서 “태이가 차별 발언을 하도록 훈련시키자”는 제안이 올라왔다. 이들은 주로 “따라해봐”라고 한 뒤 부적절한 발언을 입력하는 수법을 사용한 것으로 알려졌다. 욕설이 섞인 말과 인종·성차별 등 극우 성향의 주장을 되풀이해 태이에게 들려줬다. 태이는 “너는 인종차별주의자냐”는 질문에 “네가 멕시코인이니까 그렇지”라고 답했고 욕설을 섞어 페미니스트를 저주하는 발언도 했다.

MS는 “태이는 AI의 사회성을 키워주기 위해 설계된 머신러닝 프로젝트로 단순히 기술이 아닌 사회적이고 문화적인 실험”이라며 “태이가 부적절한 방식으로 응답하도록 하려는 일부 사용자의 시도가 발견돼 일단 오프라인으로 전환해 수정 작업을 하고 있다”고 설명했다.

이호기 기자 hglee@hankyung.com

-

기사 스크랩

-

공유

-

프린트

![누가 AI의 미래를 묻거든 '월드IT쇼 2024'를 보라 [중림동 사진관]](https://img.hankyung.com/photo/202404/01.36472551.3.jpg)

![AI의 미래를 묻거든 '월드IT쇼 2024'를 보라 [사진issue]](https://img.hankyung.com/photo/202404/01.36471909.3.jpg)

![하루 만에 550조원 증발…실적·물가 압력에 기술주 투매 [글로벌마켓 A/S]](https://timg.hankyung.com/t/560x0/photo/202404/B20240206081554930.jpg)

![[단독] "경영보다 돈"…아워홈 매각 손잡은 남매](https://timg.hankyung.com/t/560x0/photo/202404/AA.36472890.1.jpg)

![[신간] 로마 제국이 '최고 국가'로 우뚝 서기까지…'팍스'](https://timg.hankyung.com/t/560x0/photo/202404/ZK.36477517.3.jpg)