'두 얼굴'의 페이스북 콘텐츠 관리

영국 가디언, 문서 입수 '폭로'

인종차별 발언 글도 방치, 살해위협 문구는 지침 모호

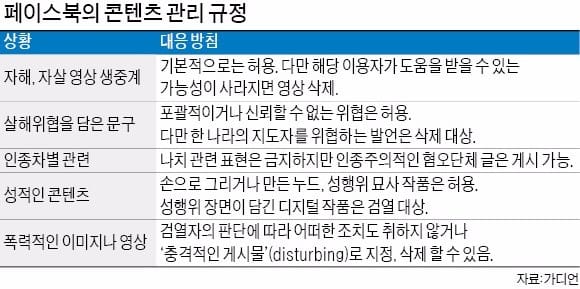

영국 가디언지는 페이스북의 콘텐츠 관리 규정을 담은 내부 문서 100건 이상을 입수해 21일(현지시간) 관련 내용을 보도했다. 가디언의 검토 결과 페이스북은 폭력과 헤이트 스피치(특정 민족·인종·국민을 향한 혐오 발언), 테러리즘, 포르노그래피, 인종주의, 자해 등의 항목에서 검열 기준을 마련한 것으로 확인됐다.

유출된 문서에는 윤리적으로 논란이 될 만한 항목이 여럿 포함된 것으로 드러났다. 페이스북은 네티즌이 생방송 서비스를 이용해 자해를 시도하는 장면을 올리는 것을 허용했다. 누군가의 도움이 필요한 사람들을 검열하거나 처벌을 원치 않기 때문이라는 이유에서다. 다만 이들을 도울 기회가 없다고 판단되면 추후 영상을 삭제하도록 했다. 가디언은 “일부 이용자는 이 같은 지침을 불편하게 느낄 수 있다”며 “소셜미디어 윤리를 둘러싼 논쟁을 불러일으킬 것으로 보인다”고 분석했다.

아동이나 동물을 성적으로 학대하는 것은 금지했다. 다만 성적이지 않은 학대는 일단 게재를 허용하되 ‘불편함(disturbing)’이라는 딱지를 붙여 게시토록 했다. 학대 신고 등의 조치도 별도로 하지 않는다는 게 페이스북의 방침이다.

페이스북은 성적인 측면에서도 표현의 자유를 보장했다. 손으로 그리거나 만든 누드, 성행위 작품은 올릴 수 있도록 했다. 단 성행위 장면이 담긴 디지털 작품은 금지했다.

이처럼 표현의 자유를 중시한 페이스북의 지침은 비판에 직면해 있다. 페이스북의 생방송 서비스가 길 가는 행인을 이유 없이 살해하거나 여학생을 집단 성폭행하는 장면을 생중계하는 도구로 쓰이면서 콘텐츠 관리 문제가 도마 위에 올랐기 때문이다. 마크 저커버그 페이스북 최고경영자(CEO)는 지난 3일 “콘텐츠 내용물 감시를 강화하기 위해 직원 3000명을 추가로 고용할 것”이라고 말했다.

한편 방송통신위원회는 페이스북의 전기통신사업법상 금지행위 위반 여부 등을 점검키로 했다고 22일 발표했다. 페이스북은 국내 특정 통신사업자의 접속 경로를 임의로 변경해 일부 가입자의 페이스북·인스타그램 접속을 제한했다는 의혹을 받고 있다.

유하늘 기자 skyu@hankyung.com

-

기사 스크랩

-

공유

-

프린트

![중동 긴장감 완화에 안도…나스닥 1.11%↑ [뉴욕증시 브리핑]](https://timg.hankyung.com/t/560x0/photo/202404/ZA.36447545.1.jpg)

![[단독] 20代 사기범죄율 1위, 대한민국](https://timg.hankyung.com/t/560x0/photo/202404/AA.36494722.3.jpg)